Entre le certain et l’incertain, un siècle de controverses sur la fondation des Mathématiques (et de la physique) ou une petite histoire (un peu ) philosophique de l’ordinateur.

par Badreddine Belhamissi |  |

| Résumé Dans la Calculabilité la théorie des Nombres est le fer de lance du déterminisme et sert de référent [c’est en réalité en dernier ressort l’espace-nodal dans lequel on va immerge les problèmes]et par exemple, la preuve de l’existence de problèmes indécidables dans les systèmes formels (suffisamment complexes pour générer les entiers ) se ramène à la preuve de l’existence d’un problème indécidable en théorie des nombres moyennant la construction d’une isomorphie où les opérations sur les chaînes sont ramenés à des opérations sur les nombres et grâce à un raisonnement diagonal à la manière de Cantor |

|

G.J. CHAITIN: [« Algorithmic information theory ».Cambridge University press. 1987.°]

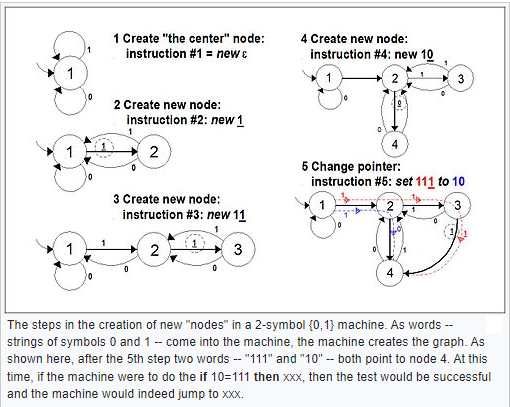

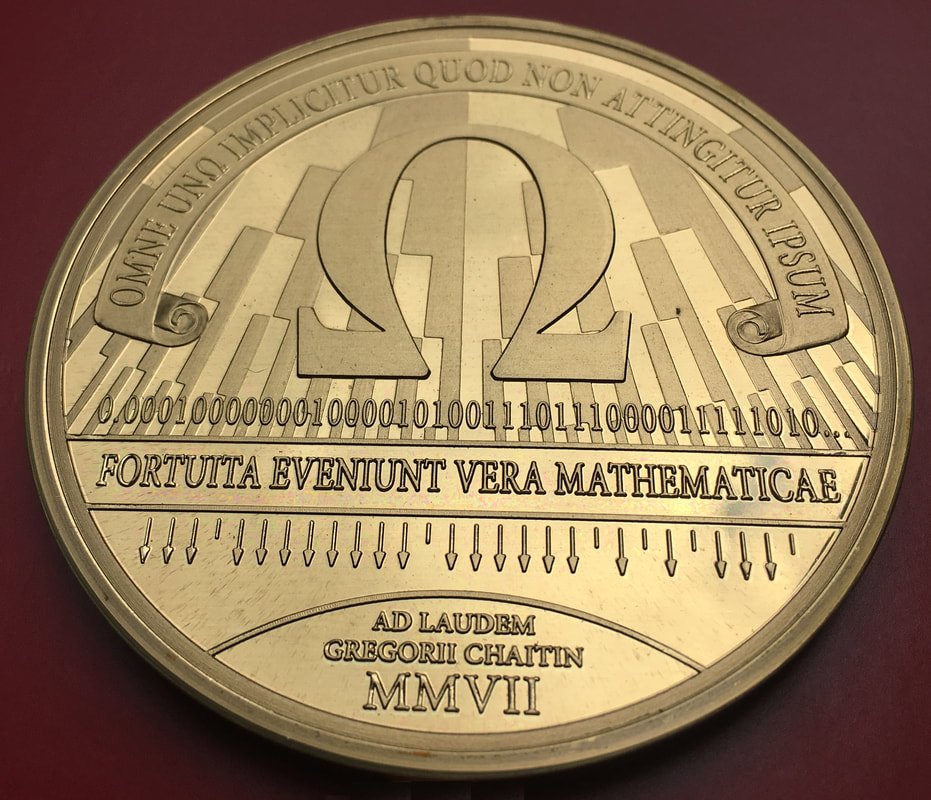

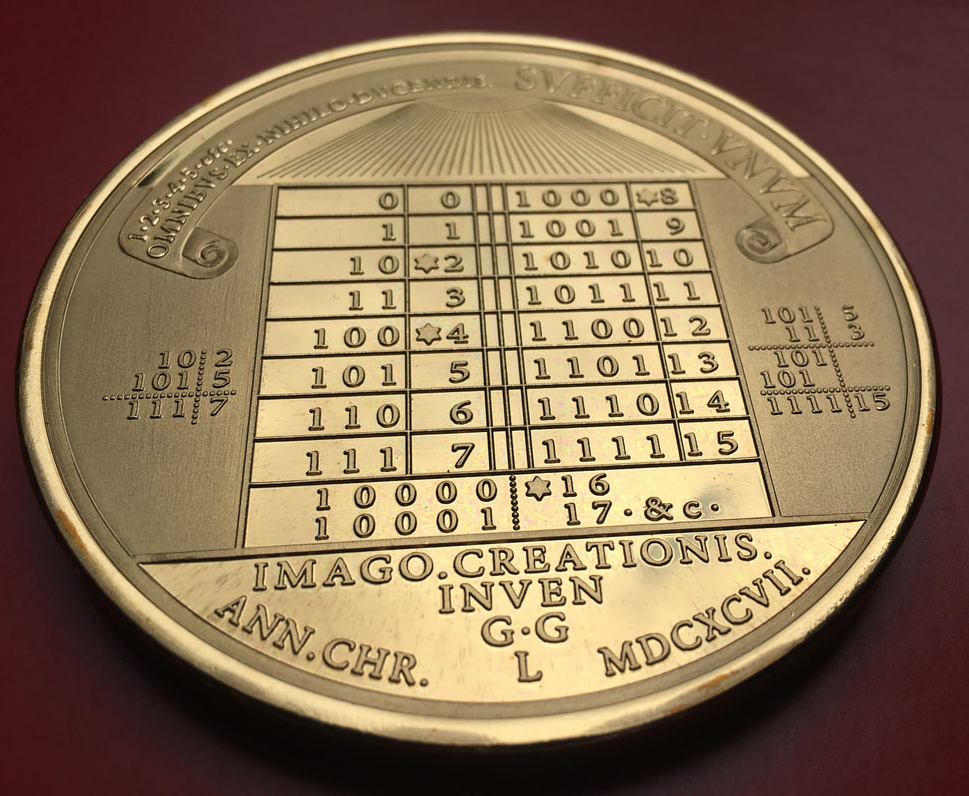

G.J. CHAITIN a montré que la théorie des Probabilités, fer de lance du non-déterminisme, peut aussi servir de référent aux problèmes de la Calculabilité. Ainsi le célèbre problème de l’arrêt d’une machine Turing est généralisé en terme de Probabilité d’arrêt d’une machine de Turing. A partir du concept de complexité introduit dans les années 1950 par Kolmogorov, [qui se trouve, par hasard , être aussi le concepteur-stabilisateur de la théorie des Probabilités] Chaïtin développe la notion d’ensembles compressibles et d’ensembles incompressibles qui le conduisent à la notion de programmes minimaux(au sens de Kolmogorov C'est, ne l'oublions pas, Kolmogorov qui a introduit les K-complexes, en tant que machine abstraite à calculs dès les années 1950 et son concept a été publié pour la première fois en 1954 (en anglais) par son élève et continuateur USPENSKI qui développe son travail en calculabilité . Machines de Kolmogorov-Uspenski  Afin de tester la robustesse de la définition de Turing, Kolmogorov et Uspenski en 1958 imaginent de remplacer le ruban linéaire de Turing par un ruban en forme de graphe non orienté qui peut se modifier au cours du calcul. Lecture, écriture et modification du ruban (suppression ou adjonction d’un nœud) se faisant toujours de façon locale, là où la tête se trouve. On suppose que le graphe reste de degré borné fixé, c’est-à-dire que le nombre de voisins d’un sommet quelconque est toujours ≤ k pour un k fixé indépendant du sommet. Gregory Chaitin défini alors le nombre Oméga comme la probabilité d’arrêt d’une machine de Turing. Chaïtin est probablement le premier chercheur à donner des résultats crédibles sur les renforcements (on pourrait aussi dire les aggravations) du théorème de Gödel, et montre que les choses sont pires que ce que le théorème de Gödel ou le théorème de Turing laissaient prévoir sur les systèmes formels. Oméga, la probabilité d’arrêt d’une machine de Turing s’avère être non seulement être un nombre transcendant mais encore plus difficile que tous les nombres transcendants que nous connaissons comme p ou e qui, eux au moins, ont la bonne idée de se laisser approcher par des algorithmes accélérables. Les limitations des systèmes sont non seulement un question d’actualité réaliste de notre monde technologique mais aussi une caractéristique inhérente des systèmes abstraits. En n’hésitant pas à paraphraser Chaïtin nous proposons une lecture détendue et transhistorique de certains événement clés qui nous paraissent être à la source du changement et du devenir du concept que nous avons de la certitude et de la précision dans le monde des mathématiques, en tant que langage déclaré de cette certitude et de cette précision depuis un siècle, mais aussi dans la physique en tant qu’univers ultime de la réalité que décrit ce langage. |

|

|

La machine de Turing

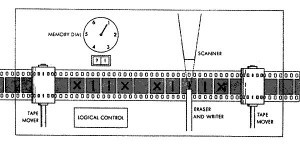

Le modèle de Turing est un modèle abstrait d’ordinateur composé d’un mécanisme de calcul et d’un ruban sur lequel la machine écrit et qu’elle peut effacer en d´epla¸cant une tête de lecture-écriture. Chaque machine de Turing est associée à un programme qui détermine avec une précision absolue les opérations qu’elle effectue. Alan Turing démontre qu’il existe un type de machine de Turing (dite universelle) capable de simuler toute autre machine de Turing. Une fonction Turing calculable est une fonction dont on est capable de construire une description algorithmique de calcul pour une machine de Turing. Un programme de machine de Turing se compose d’une suite finie composée de symboles. On peut associer à ce programme un nombre appelé index de la machine de Turing. Les machines de Turing sont énumérables, et donc dénombrables, et on les note Mi.Le problème de l’arrêt

On démontre qu’il existe des fonctions non calculables : la première d’entre elles est la fonction qui, pour tout programme donné P, indique (a) si le programme finit par s’arrêter ou (b) s’il continue indéfiniment à calculer. Effectivement, Turing démontre que cette fonction n’est pas calculable, c’est ce qu’on nomme le problème de l’indécidabilité de l’arrêt.En d’autres termes, il n’existe aucune machine de Turing qui sait déterminer si une autre machine va s’arrêter pour un programme avec une entrée quelconque.

Beaucoup d’autres problèmes sur les machines de Turing ne sont pas décidables.

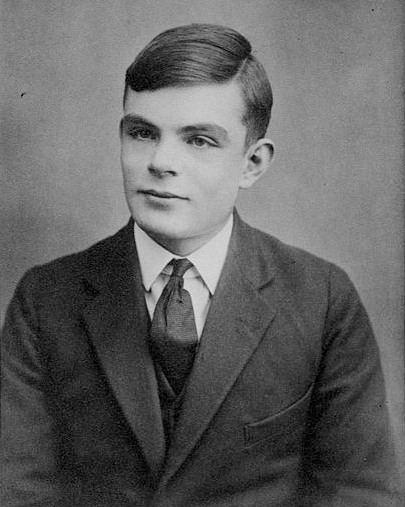

- Alan Mathison Turing naît le 23 juin 1912 à Londres.

- Son père est administrateur colonial à Madras en Inde.

- Au Malborough Collège, ses dons hors du commun sont vite reconnus.

- Adolescent réfractaire à la culture classique, son goût pour les sciences et son homosexualité le marginalisent à la Sherborne School.

- A 17 ans, Turing comprend les recherches d'Einstein, mais connaît des échecs répétés à ses examens. En 1931, il intègre le King's College de l'Université de Cambridge où il trouve un milieu plus favorable pour étudier les mathématiques.

Alan Turing âgé de 16 ans | Wikimedia Commons

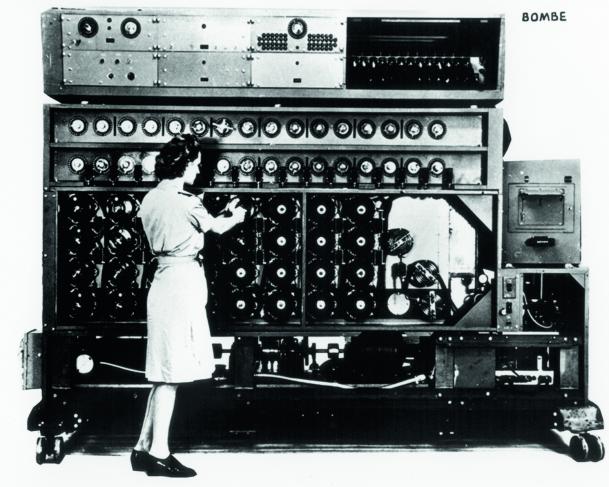

En 1939, Alan Turing revient enseigner à Cambridge où il assiste au cours de Wittgenstein qui prétend dissoudre la logique mathématique ! La Seconde Guerre mondiale éclate et Turing s'engage dans l'armée britannique où il travaille à Bletchley Park au déchiffrement des messages de la marine allemande.

Enigma

Son apport est essentiel, car Turing améliore la "bombe" polonaise, un dispositif qui permet de déchiffrer le code des machines

Enigma utilisées par le commandement nazi.

Cette « bombe », machine pour décrypter les messages codés, est un modèle de l’US Navy construite d’après

les « bombes » anglaises, avec l’aide d'Alan Turing.

Les Nazis codaient leurs messages avec des machines qui permutaient les lettres tapées sur le clavier.

Le modèle utilisé par la marine fut craqué dès 1942 par les Anglais avec l’aide d'Alan Turing.

Après la guerre, Alan Turing travaille au National Physical Laboratory et conçoit un prototype de calculateur électronique,

l'ACE ( Automatic Computing Engine), qui prend du retard dans sa réalisation.

Aussi il rejoint l'Université de Manchester qui avait construit en 1948 le premier ordinateur programmable opérationnel, le Mark 1.

Turing participe à la programmation et se passionne pour l'intelligence artificielle.

Il élabore un test qui valide l'intelligence d'une machine, le fameux "test de Turing."

Parallèlement, il s'intéresse aux phénomènes de croissance animale et végétale qui le conduisent aux « structures de Turing ».

Élu membre de la Royal Society, Turing éprouve de graves difficultés quand la révélation de son homosexualité provoque un scandale en 1952.

C'est un crime pour la justice britannique. Le procès le condamne à la prison.

Pour éviter l’enfermement, Alan Turing est contraint d'accepter la castration chimique, mais sa carrière est brisée.

Il se suicide à 42 ans en croquant une pomme trempée dans du cyanure le 7 juin 1954.

Kolmogorov

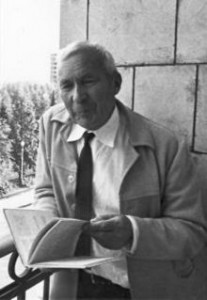

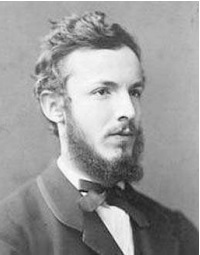

Andreï Nikolaïevitch Kolmogorov (en russe : Андрей Николаевич Колмогоров ) né le 25 avril 1903 à Tambov.

On appelle nombre incompressible au sens de Kolmogorov un nombre réel dont le développement binaire est comparable à la taille de l'algorithme qui permet de le calculer.

En ce sens tous les rationnels et certains irrationnels sont compressibles en particuliers les nombres transcendants comme pi (π ) et e.

A partir du concept de complexité introduit dans les années 1950 par Kolmogorov, [qui se trouve, par être aussi le de la théorie des Probabilités] développe la notion d’ensembles compressibles et d’ensembles incompressibles qui le conduisent à la notion de programmes minimaux(au sens de Kolmogorov, qui n’oublions pas a introduit les K-complexes, en tant que machine équivalente à la machine de Turing, dès les années 1950 et a été publié pour la première fois en 1954 (en anglais), c’est USPENSKI, son continuateur qui développe son travail en calculabilité)

Andreï Nikolaïevitch Kolmogorov (en russe : Андрей Николаевич Колмогоров ) né le 25 avril 1903 à Tambov.

On appelle nombre incompressible au sens de Kolmogorov un nombre réel dont le développement binaire est comparable à la taille de l'algorithme qui permet de le calculer.

En ce sens tous les rationnels et certains irrationnels sont compressibles en particuliers les nombres transcendants comme pi (π ) et e.

A partir du concept de complexité introduit dans les années 1950 par Kolmogorov, [qui se trouve, par être aussi le de la théorie des Probabilités] développe la notion d’ensembles compressibles et d’ensembles incompressibles qui le conduisent à la notion de programmes minimaux(au sens de Kolmogorov, qui n’oublions pas a introduit les K-complexes, en tant que machine équivalente à la machine de Turing, dès les années 1950 et a été publié pour la première fois en 1954 (en anglais), c’est USPENSKI, son continuateur qui développe son travail en calculabilité)

La notion de complexité algorithmique (appelée aussi parfois entropie algorithmique) est apparue dans les années 1960 entre la théorie du calcul, la probabilité

théorie et théorie de l'information.

L'idée d'A. N. Kolmogorov était de mesurer la quantité d'informations

en objets finis (et non en variables aléatoires, comme cela se fait dans le Shannon classique

théorie de l'information). Son célèbre article [78], publié en 1965, explique comment cette

peut être fait (jusqu'à un terme additif borné) en utilisant l'approche algorithmique.

Des idées similaires avaient été suggérées quelques années plus tôt par R. Solomonoff. La motivation de Solomonoff était tout autre. Il a essayé de définir la notion de probabilité a priori.

Imaginez qu'il y ait une expérience (processus aléatoire) et nous ne savons rien de sa structure interne. Pouvons-nous dire quelque chose sur la probabilité de résultats différents dans cette situation ?

On peut mettre cela en relation avec le mesures de complexité indiquant que des objets simples ont une plus grande probabilité a priori

que les plus complexes. (Malheureusement, le travail de Solomonoff n'est devenu populaire qu'après que Kolmogorov l'ait mentionné dans son article.)

En 1965, G. Chaitin (alors étudiant de premier cycle âgé de 18 ans) a soumis deux articles ; ils ont été publiés en 1966 et 1969, respectivement. Dans le deuxième article, il a proposé la même définition de la complexité algorithmique que Kolmogorov.

Les propriétés de base de la complexité de Kolmogorov ont été établies dans les années 1970.

Travaillant de manière indépendante, С. P. Schnorr et L. Levin (qui fut élève de Kolmogorov) ont trouvé un lien entre la complexité et la notion d'aléatoire algorithmique (introduite en 1966 par P. Martin-Löf [115]). Pour y parvenir, ils ont introduit une version légèrement différente de la complexité, la soi-disant complexité monotone. Également

Les idées de Solomonoff sur la probabilité a priori ont été formalisées sous la forme de préfixe de complexité, introduit par Levin et plus tard par Chaitin. Les notions de complexité s'est avéré utile à la fois pour la théorie du calcul et la théorie des probabilités.

La complexité de Kolmogorov est devenue populaire (et pour cause : c'est une base et une notion philosophiquement importante de la théorie des algorithmes) d'après M. Li et P. Vitânyi qui ont publié un livre sur le sujet (première édition parue en 1993).

De Kolmogorov à Chaïtin

Chaïtin à partir de la notion d’ensembles compressibles et d’ensembles incompressibles développe la notion de programmes minimaux (au sens de Kolmogorov.) Gregory Chaïtin défini le nombre Oméga comme la probabilité d’arrêt d’une machine de Turing. |

" " |

" " |

| Le nombre Ω appartient à une famille infinie de nombres, les nombres oméga de Chaïtin. Ces nombres oméga sont déconcertants, car chacun concentre une conjonction invraisemblable d'étrangetés. Une sous-classe des nombres oméga de Chaitin, les nombres oméga de Solovay aggravent encore le tableau. Ces classes de nombres bizarres sont aussi importantes que les classes des nombres rationnels, algébriques ou transcendants. | ||

|

||||||||||||

|

||||||||||||

Solovay, Robert M.

|

La probabilité d’arrêt d’une machine de Turing s’avère être non seulement être un nombre transcendant mais encore plus difficile que tous les nombres transcendants que nous connaissons comme π ou e (la base de la fonction logarithme népérien, notée e, appelée nombre de Néper ou nombre d'Euler. Sa valeur approchée est : e≈2,718281828459045235360....) qui, eux au moins, ont la bonne idée de se laisser approcher par des algorithmes accélérables. Un nombre Oméga de Chaïtin est une suite de bits représentant, sous forme concentrée, la solution du problème de l'arrêt pour tous les programmes d'une machine de Turing universelle donnée. |

Les limitations des systèmes sont non seulement un question d’actualité réaliste de notre monde technologique mais aussi une caractéristique inhérente des systèmes abstraits.

En n’hésitant pas à paraphraser Chaïtin nous proposons une lecture détendue et transhistorique de certains événement clés qui nous paraissent être à la source du changement et du devenir du concept que nous avons de la certitude et de la précision dans le monde des mathématiques, en tant que langage déclaré de cette certitude et de cette précision depuis un siècle, mais aussi dans la physique en tant qu’univers ultime de la réalité que décrit ce langage.

Métamathématique, vous avez dit ?

Et le langage peut-il se décrire lui-même ?

Alonzo Church,14 juin 1903 Washington 11 aout 1995 | Alonzo Church est né le 14 juin 1903 à Washington.

D’après Chaïtin, si on regarde un peu attentivement les écrits des logiciens du début du siècle

à la lumière de notre expérience actuelle de l’utilisation intensive de l’ordinateur, *on remarque que le lambda calcul d’Alonzo Church est une sorte de langage de programmation fonctionnelle, *que le langage de Turing est une sorte de langage machine justement *et que les écrits originaux de Gödel contiennent un formalisme qui ressemble furieusement à notre LISP actuel ! Mais, LISP n’est-ce pas ce bon vieux langage qu’a mis au point John McCarthy dans les années 1950 comme exemple de langage à sémantique opérationnelle implémentant les idées sur la récursivité des logiciens Italiens dignes élèves de Peano ?  Giuseppe Peano Mais oui c’est bien LISP ce curieux langage qu’on utilise encore aujourd'hui et qui se laisse spécifier par lui-même ! |

John McCarthy (né le 4 septembre 1927, à Boston) il est le principal pionnier de l'intelligence artificielle avec Marvin Lee Minsky |

Marvin Lee Minsky, né le 9 août 1927 à New York et mort le 24 janvier 2016 à Boston, est un scientifique américain. Il a travaillé dans le domaine des sciences cognitives et de l'intelligence artificielle. |

Le formalisme pour décrire ou pour raisonner ?

|

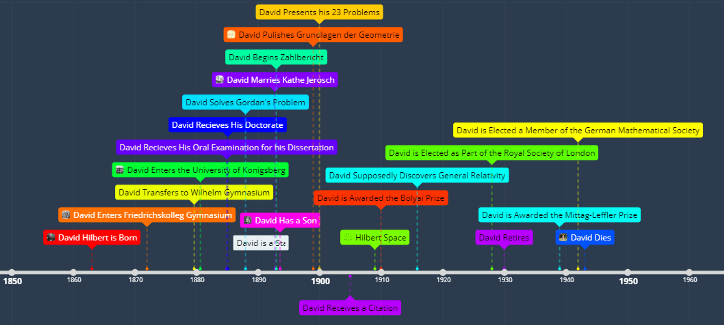

David Hilbert est né le 23 janvier 1862 à Königsberg (Prusse orientale). Il étudie dans le lycée de la ville puis dans son université jusqu'à sa thèse sous la direction de Lindemann, la premier à démontrer que pi est transcendant (ce qui signifie qu'il n'existe aucun polynôme à coefficients rationnels dont pi soit une racine). Il y enseigne à partir de 1886 jusqu'en 1895, date à laquelle il part à Göttingen. Il épouse en 1892 Käthe Jeroch avec qui il aura un fils. Il gardera toujours son poste à Göttingen, probablement parce que la ville est alors un centre culturel (pas seulement en mathématiques). On sait que le projet de Hilbert était de formaliser complètement la Mathématique et le raisonnement Mathématique. Le 8 août 1900 à Paris, Hilbert énonce un ensemble de 23 problèmes qu'il considère comme fondamentaux et qui effectivement seront des fers de lance de la recherche mathématique du XXème siècle. Il décède le 14 février 1943 à Göttingen. Hilbert est surtout connu pour les espaces éponymes, qui généralisent la notion de produit scalaire vue en France en première. Il est également très connu dans le domaine de l'algèbre car il est l'auteur du « théorème des zéros » (en allemand « Nullstellensatz »), un théorème d'une importance capitale, qui pose les bases de la géométrie algébrique. Il s'est également intéressé à la théorie des nombres et a publié Zahlbericht (Rapport sur les nombres, 1897) où il synthétise notamment les recherches de Kümmer, Kronecker et Dedekind. |

Ce courant mathématique s'oppose à l'analyse constructive.

Cette dernière n'admet que les preuves constructives (c'est-à-dire les preuves qui lorsqu'elles utilisent un objet en donnent une construction explicite) alors que Hilbert donne plus grande part aux axiomes.

C'est le point de vue de Hilbert qui domine aujourd'hui les mathématiques (même si le point de vue constructif reste étudié par des spécialistes) et c'était même une des idées directrices de la réforme dite des « mathématiques modernes » dans les années 60.

Il a également travaillé en physique, où il est surtout reconnu comme celui qui a apporté les outils nécessaires à Einstein pour formuler la relativité générale (certains lui attribuent même la parenté des équations d'Einstein, mais cette thèse est controversée).

Hilbert fut également un des soutiens de la mathématicienne Emmy Noether.

Très importante pour l'algèbre commutative (certains anneaux portent son nom), elle ne pouvait pas enseigner car les femmes universitaires étaient mal vues en Prusse.

Hilbert l'a autorisée à utiliser son nom pour ses cours.

Une légende raconte qu'Hilbert était tellement distrait qu'un jour où sa femme lui demanda de se changer pour recevoir des invités, il s'est mis au lit après s'être déshabillé. On dit d'Hilbert qu'il était avec Poincaré (on rapproche souvent ces deux figures) le dernier mathématicien à maîtriser l'ensemble des mathématiques.

Sa devise, gravée sur sa tombe, était « Wir müssen wissen. Wir werden wissen. » (Nous voulons savoir, nous saurons).

Il est amusant de savoir que la veille du jour où il prononça pour la première fois cette phrase publiquement, Gödel déposait sa thèse où il invalide l'objectif de Hilbert.

Gödel et après lui Turing ont montré que cela n’était pas possible. Mais cet échec de la formalisation du raisonnement a néanmoins été une réussite dans la formalisation des algorithmes, c’est la vraie mèche responsable de l’explosion Babelienne du foisonnement de la technologie actuelle des langages de programmation informatique. Ce n’est peut-être pas complètement vrai, mais on peut dire que Turing a inventé l’ordinateur pour répondre à la question plutôt philosophique posée par Hilbert. Il est par ailleurs scandaleusement comique de voir qu’une problématique rationnelle sur la notion de certitude philosophique ait débouché sur une course frénétique et jubilatoire aux supers méga gains dans le marché aux ordinateurs. Ce que Gödel et Turing ont montré :c’est que le raisonnement axiomatique formel possèdes limitations.

On ne peut formaliser le raisonnement axiomatique dans son entier.

Maintenant, nous devons à la vérité de dire qu’il y a toujours eu des crises dans l’histoire des Mathématiques.

Car la Mathématique, comme les autres domaines du monde abstrait d’ailleurs, évolue et se complexifie.

Les trous de Pythagore

| Une des premières crises fut vécue par les Pythagoriciens quand ils ont dû constater que la racine de deux était irrationnelle. Cette longueur de la diagonale du carré unité, qui était donc un objet réel, ne pouvait pas s‘écrire comme fraction de deux entiers. A cette époque le monde des fractions représentait la totalité connue du mode numérique . Et l’intuition Pythagoricienne qu’à chaque objet réel il corresponde un nombre (et donc une fraction) [et même aussi une signification ]conduisait à concevoir la droite comme une juxtaposition de points représentants ces nombres. Or donc, la longueur de la diagonale du carré était à la fois dans droite mais en aucun point (i.e. fraction) connu ! On était dans un trou. L’idée de Pythagore s’écroule, il existe des longueurs incommensurables. Son dogme « tout est nombre » ne retrouvera vie que dans les temps modernes, quand d’autres « objets » seront admis dans le champ des nombres, en particulier, le rapport de la diagonale au côté du carré, racine de 2 que nous disons irrationnel, non pas parce que ce nombre ne serait pas raisonnable mais parce qu’il ne s’agit pas d’un rapport d’entiers. |

La droite de Pythagore était remplie de trous.

(L’histoire montrera que ces trous caractérisent plus fidèlement la droite réelle que les rationnels de Pythagore)

Le fait que c’était une crise justement a survécu actuellement dans le mot même d’irrationnel.

Il faut se souvenir que les Grecs pensaient que la rationalité était l’objectif suprême.

Platon! la Raison !

Si donc un nombre était qualifié d’irrationnel, cela dit tout le trouble vécu à l’époque et on peut considérer que c’était l’équivalent du théorème de Gödel des anciens Grecs.

Il y eut d’autres convulsions mathématiques. Par exemple, la crise du raisonnement infinitésimal de l’Analyse ou la crise du fameux postulat d’Euclide sur les parallèles et l’émergence des géométries Non-euclidiennes.

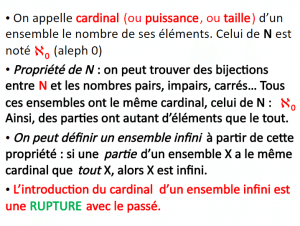

Transfinis, Kézako ?

Mais la crise qui nous intéresse est née il y a un peu plus d’un siècle et est dûe au travail de Cantor sur la théorie des ensembles. Cantor : Théorie des Ensembles Infinis.

Cantor : Théorie des Ensembles Infinis.

| Déjà Euclide avait démontré que les nombres premiers étaient en nombre infini Soit P le nombre premier supposé le plus grand. // Soit Q le produit plus 1 de tous les nombres premiers inférieur ou égaux à P : Q = 2.3.5.7....P + 1 //Aucun des nombres premiers n'est diviseur de Q; il reste toujours 1. // Q est soit premier, ou produit de nombres premiers plus grands que P. // Dans les deux cas, il existe un nombre premier plus grand que P. // Donc il n'existe pas de nombre premier le plus grand. // Ils sont en nombre infini. |

de l'Apeiron à l'Infini

Infini potentiel : infini vu comme un processus qui peut se prolonger arbitrairement longtemps (par exemple diviser unequantité)c'est Aristote en effet qui distinguait "l'infini actuel" de "l'infini potentiel" dans l'esprit d'Aristote, c'est limite obtenue par divisions successives (convergence) ou par additions successives (divergence)

Infini actuel : c’est la possibilité de considérer l'infini comme une entité achevée

| Citons Hervé Lehning (Normalien, agrégé de mathématiques) qui nous dit: c'est le véritable infini, celui que refusent les physiciens, c''est l'infini actuel.

Le mot « actuel » doit ici être pris dans le sens de « effectif », comme le « actual » anglais.

L'envisager dans certains calculs est intéressant en mathématiques où la considération de quantités infiniment petites permet de résoudre certains problèmes.

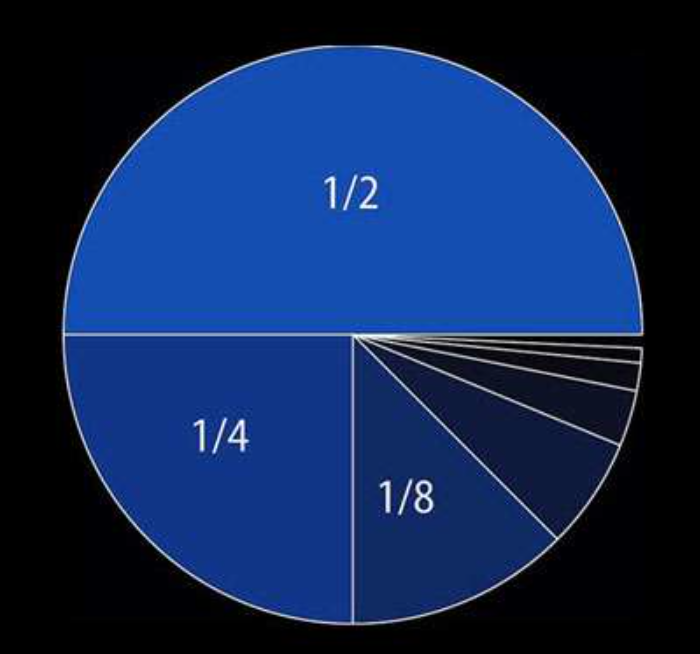

Cette notion permet également de considérer des sommes infinies comme : S = 1/2 + 1/4 + 1/8 + 1/16 + etc. Leur donner un sens est une affaire plus délicate. Dans ce cas, le petit dessin à gauche aide à le faire : Ce partage géométrique montre que : S = 1. Il reste que ce partage ne peut se réaliser que dans l'idéal car, très vite, les portions fractionnaires du cercle résultant du processus de la découpe deviennent de plus en plus petites et la limite de notre perception est dépassée. |

| L'apeiron (en grec ancien : ἄπειρον / apeiron, « illimité ») est un concept philosophique présenté la première fois par Anaximandre au vie siècle av. J.-C. pour désigner ce principe originel que recherchaient les tenants de l'école milésienne. Thalès voyait en l'eau le principe originel, la substance de toute chose. Pour Anaximandre, c'est l'apeiron, qui signifie « illimité, indéfini, indéterminé », qui est le principe et l'élément de tout ce qui existe. L’apeiron est inaccessible à la sensibilité, mais il doit exister. Il est nécessaire pour expliquer l’existence de tout ce que nous percevons. Il ne peut posséder de qualité déterminée et n'est désigné que négativement. |

|

Au 18e siècle, Blaise Pascal écrit, au sujet des deux infinis, l'infiniment petit et l'infiniment grand:" ces extrémités se touchent et se réunissent à force de s'être éloignées, et se retrouvent en Dieu et en Dieu seulement. " Car enfin qu'est-ce que l'homme dans la nature ? Un néant à l'égard de l'infini, un tout à l'égard du néant, un milieu entre rien et tout. Infiniment éloigné de comprendre les extrêmes, la fin des choses et leur principe sont pour lui invinciblement cachés dans un secret impénétrable, également incapable de voir le néant d'où il est tiré, et l'infini où il est englouti. |

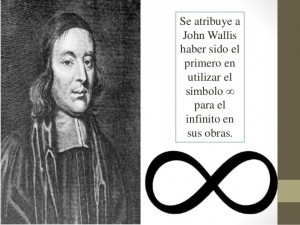

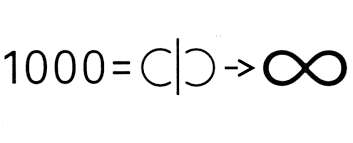

| Ce symbole était utilisé par les Romains pour représenter 1000, puis un grand nombre. En 1665, John Wallis, Professeur à Oxford, utilisa ce symbole pour désigner l'infini pour la première fois dans " Arithmetica Infinitorum " |

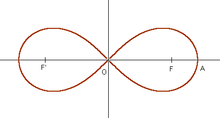

| « ∞ » ou (U+221E, \infty {\displaystyle \infty }\infty en LaTeX) est le symbole représentant l'infini. Il a été inventé par le mathématicien John Wallis en 1655 dans De sectionibus conicis (littéralement : des sections coniques), donc antérieurement à Jacques Bernoulli (qui est né en 1654). Néanmoins, sa forme est similaire à la lemniscate de Bernoulli et à certaines configurations du ruban de Möbius. Une lemniscate est une courbe plane ayant la forme d'un 8, le terme vient du grec ancien λημνισκος par le latin lemniscus qui signifie justement ruban. Selon la police d'écriture et la fonte de caractères, ce symbole peut comporter des pleins et des déliés ou non, modifiant ainsi sa symétrie. |

Leonhard Euler | Symbole utilisé par Euler pour désigner l'infini. Une variante non fermée du symbole, plus du tout usitée dans la typographie, a été couramment utilisée au xviiie siècle, en particulier par Leonhard Euler, qui l'appelle absolutus infinitus, par opposition à d'autres quantités infinies qu'il construit à partir de ce « nombre infini absolu » (comme son logarithme par exemple). Le symbole de proportionnalité ∝ est également assez similaire. Usage dans les notices biographiques On emploie parfois le signe de l'infini dans les notices biographiques comme symbole du mariage. Accolé à une date, il indique celle de la cérémonie. Mais, il ne fut généralisé qu'en 1713 grâce à son adoption par Bernoulli Jacques ou Jakob Bernoulli (1654-1705) est un mathématicien et physicien suisse (né et mort à Bâle) |

|   Le symbole actuel de l'infini qui n’est autre la lemniscate de Bernoulli stylisée (il représente un huit couché ou huit paresseux.

en mathématique, c'est une lemniscate dont on peut suivre le parcours indéfiniment (à rapprocher aussi du ruban de Möbius et de son parcours pareillement indéfini).) était déjà utilisé par les romains pour représenter 1000, puis un grand nombre.

Le symbole actuel de l'infini qui n’est autre la lemniscate de Bernoulli stylisée (il représente un huit couché ou huit paresseux.

en mathématique, c'est une lemniscate dont on peut suivre le parcours indéfiniment (à rapprocher aussi du ruban de Möbius et de son parcours pareillement indéfini).) était déjà utilisé par les romains pour représenter 1000, puis un grand nombre. |

| Au 19e siècle, Bolzano publie Les paradoxes de l’infini. Avec lui commence l’histoire moderne de l’infini mathématique. Il découvre que le cardinal des segments [0,1] et celui du segment [0,2] sont identiques.

Il est le premier à défendre l'idée que l'infini peut être introduit en calcul mathématique et dans le calcul infinitésimal en particulier. Il est le premier à fonder une vision mathématique de l’infini actuel. En caractérisant un ensemble par ses propriétés, sa totalité est appréhendée. Inutile d'énumérer tous les éléments. Bernard Bolzano (1781-1848) est le premier à défendre l'idée que l'infini peut être introduit en calcul mathématique et dans le calcul infinitésimal en particulier. |

Gauss (1777-1855) y était opposé! |

Questions sur les ensembles infinis

L’introduction des ensembles infinis pose des problèmes nouveaux et délicats.

Y a-t-il plusieurs sortes d’ensembles infinis ?

Sont-ils tous de la mˆeme taille ?

Peut-on les comparer entre eux ?

Est-ce que tout ceci a un sens ? Est-ce que ¸ca a un sens de parler de la « taille » d’un ensemble infini, et si oui, avec quelle unité la mesurer ?

Les ensembles infinis aboutissent parfois `a des situations qui défient un peu l’intuition.

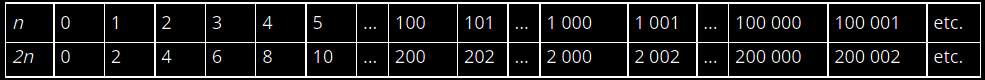

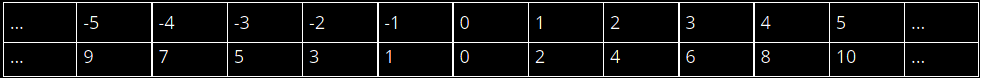

Question 1 : y a-t-il autant d'entiers naturels que d'entiers naturels pairs ?

Les nombres pairs sont bien sûr : 0, 2, 4, 6, 8, 10, … , 98, 100, … , 998, 1000, etc.

Il y en a bien sûr une infinité...

Construisons ce qu'on appelle une correspondance biunivoque entre chaque entier et chaque nombre pair

à tout entier naturel n, on associe l'entier naturel 2n, qui est pair. on obtient le tableau suivant:

On peut constater que chaque entier naturel n correspond au nombre pair 2n, et réciproquement on peut « relier » tout nombre pair 2n à l'entier naturel n et ceci peut se faire indéfiniment

n est obligé de constaté qu'il y a donc autant d'entiers naturels que d'entiers naturels pairs !

Alors qu'intuitivement, il y a "deux fois plus d'entiers naturels" que d'entiers naturels pairs.

Question 2 : y a-t-il autant d'entiers naturels que d'entiers relatifs ?

On aurait tendance à dire non puisque les entiers relatifs sont composés des entiers naturels auxquels on ajoute les entiers négatifs

et pourtant on peut construire facilement une correspondance biunivoque entre l'ensemble des entiers et l'ensemble des entiers relatifs:

Autrement dit, à tout entier naturel n, on associe l'entier 2n, et à tout entier strictement négatif n on associe l'entier impair -2n-1. Et réciproquement…

Donc, on en déduit contrairement à notre intuition qu'il y a autant d'entiers que d'entiers relatifs.

De même, on pourrait montrer que que le nombre infini des entiers N est égal à l'infini de l'ensemble des carrés, des cubes, etc.

Il semble bien donc qu'il existe un unique infini, qu'on peut appeller infini dénombrable, puisque tous les autres ensembles infinis peuvent se ramener à celui des entiers naturels (dénombrable).

Question 3 : y a-t-il autant d'entiers naturels que de nombres réels ?

La réponse est NON, et ce fut découvert en 1891 par Georg Cantor : c'est l'argument de la diagonale de Cantor.

Supposons qu'on puisse numéroter une liste (quelconque) de réels de l'intervalle [0 ;1] :

r1 = 0, 0 1 0 5 1 1 0 …

r2 = 0, 4 1 3 2 0 4 3 …

r3 = 0, 8 2 4 5 0 2 6 …

r4 = 0, 2 3 3 0 1 2 6 …

r5 = 0, 4 1 0 7 2 4 6 …

r6 = 0, 9 9 3 7 8 1 8 …

r7 = 0, 0 1 0 5 1 3 0 … etc.

Le nombre obtenu à partir de la diagonale est : 0,0140210…

En changeant chaque décimale par sa suivante, on construit alors le nombre : 0,1251321…

Ce nombre ne peut être dans la liste ci-dessus, car il diffère de r1 par sa première décimale, de r2 par sa deuxième décimale, de r3 par sa troisième décimale, etc.

Autrement dit, pour toute liste dénombrable de réels de [0 ;1], on peut construire un réel de [0 ;1] qui n'est pas dans cette liste.

Conclusion : l'ensemble infini des nombres réels est strictement plus grand que l'ensemble infini des entiers N

De même Cantor a répondu oui à la Question 4 : y a-t-il un infini plus grand que celui des réels ?

Enfait depuis l'analyse du mouvement par Galilée et surtout avec le calcul infinitésimal inventé à la fois par Newton et Leibniz.

Un nouveau tournant survient avec et de nouveaux concepts mathématiques apparaissent : celui de fonction, de dérivée, de suite et de série infinie, de limite, de quantité infinitésimale, de différentielle, etc".

L'idée est de calculer la longueur d'une courbe en faisant la somme d'une infinité de portions de droites qui s'approchent le plus d'elle.

Cette méthode puissante démontrera que la notion d'infini peut être utilisée dans les mesures mathématiques.

| C'est Georg Cantor (1845-1918), qui découvrira de nombreuses propriétés des tailles d'ensembles infinis qui lui sembleront souvent à la limite du paradoxe. Cantor distinguera les tailles des ensembles. Si le contraire avait été vrai (c'est-à-dire si chaque ensemble infini avait pu être mis en bijection avec chaque autre), la théorie de la taille des ensembles infinis aurait singulièrement manqué d'intérêt ! Cantor s'aperçoit, en 1874, que l'ensemble des nombres réels ne peut pas être mis en bijection avec l'ensemble des nombres entiers : il est de taille strictement plus grande. | Le raisonnement diagonal que Cantor découvre en simplifiant son raisonnement de 1874 sera le prototype même du raisonnement permettant de démontrer des résultats d'impossibilité en mathématiques.

| Formellement la notion d’infini s'impose en 1873 grâce aux travaux de Georg Cantor Georg Cantor naît en 1845 à Saint-Petersbourg, d’une mère russe et d’un père homme d’affaires allemand, d’origine juive mais converti au protestantisme. Il passe ses premières années en Russie. La famille revient en Allemagne quand Georg a onze ans, d’abord à Wiesbaden puis à Francfort. Le cardinal d’un ensemble est généralisé à la notion de puissance d’un ensemble dans le cas infini Dans Les paradoxes de l'infini, Bolzano (1781-1848) allait d'abord affranchir la notion de l'infini actuel de celle de Dieu en la situant dans le champ du calcul et de la quantification plutôt que dans celui de la théologie. Pour cela, il partit de l’idée simple que quand on compare deux ensembles finis, pour qu’ils aient le même nombre d’éléments, on dit le même cardinal, cardinal étant le nombre d’éléments d’un ensemble, il suffit de pouvoir associer à chaque élément d’un ensemble un élément et un seul de l’autre et réciproquement.. Il généralisa cette idée aux ensembles infinis : deux ensembles infinis sont égaux, en terme de nombre d’éléments, s'il est possible d'établir une correspondance biunivoque entre les éléments de ces deux ensembles, c'est-à-dire s'il est possible d'associer un élément du second ensemble à chaque élément du premier et réciproquement... |

Bolzano a ainsi utilisé une démarche typiquement mathématique : définir rigoureusement un concept aussi général et abstrait que possible, ici l’infini actuel, de façon à ce que l’utilisation de cette définition permette des raisonnements cohérents..

Il ne s’agit donc pas de se demander ce que peut représenter cet infini actuel dans notre monde et l’évaluer selon un critère de vérité. Cette définition a eu des conséquences contraires à l’intuition. En effet comparons l’ensemble des nombres entiers positifs, N, et celui des nombres pairs..

À chaque nombre entier on peut associer un nombre pair et un seul, son double. .

Réciproquement, à chaque nombre pair on peut associer un nombre entier et un seul, sa moitié..

Il existe donc une relation biunivoque entre les entiers et les nombres pairs, deux ensembles infinis. .

Selon la définition de Bolzano, ces deux ensembles ont le même nombre cardinal, ils ont la même infinité d’éléments. .

C’est peu intuitif car les nombres pairs sont inclus dans les entiers qui en plus incluent les nombres impairs ! .

En fait, la définition de l’infini implique qu’un ensemble infini peut avoir le même cardinal qu’une de ses parties, infinie elle aussi ! .

Ce résultat allait contre ce qui semblait être une évidence depuis Aristote..

Les nombres constituèrent la porte d’entrée principale pour l’étude de l’infini. .

En calcul, la suite des nombre entiers est probablement le premier contact que l’on a avec l’infini.

Cantor, d'emblée, affirma l'existence de l'infini actuel. Il osa ce que personne n'avait osé depuis Aristote : la suite des entiers positifs (0, 1, 2, 3, … ) est infinie, l'ensemble des entiers positifs, N, est donc un ensemble qui a une infinité d'éléments, alors il affirma que le cardinal de cet ensemble était un nombre qui existait comme tel sans que l'on utilise le symbole fourre-tout ∞, il l'appela ℵ0. Le symbole ℵ est la première lettre de l'alphabet hébreu et se prononce aleph, ℵ0 se prononce aleph 0. Il faut signaler que Cantor est resté un juif très croyant, ce qui le tourmentera durant toute sa réflexion sur l'infini.

Cantor allait nommer ce nombre étrange, un nombre transfini, il représentait une quantité infinie.

L'acte décisif fut d'affirmer qu'il y a, après le fini, un transfini, c'est-à-dire une échelle illimitée de modes déterminés qui par nature sont infinis, et qui cependant peuvent être précisés, tout comme le fini, par des nombres déterminés, bien définis et distinguables les uns des autres. (La Recherche, # 268, p. 908).

En 1883, Cantor écrivit : Ne pas simplement considérer l’infiniment grand sous la forme de ce qui croit sans limite, mais également le fixer de façon mathématique par des nombres, cette pensée s’est imposée à moi logiquement, presque contre ma volonté.

|

Cantor montre que le nombre de points sur une droite est plus infini (transfini, disait-il) que l'infini des nombres entiers. C'est la puissance du continu, dit-il. HenriPoincaré  n'adhérait pas à ce concept La lettre cabalistique en hébreu est aleph (Ж ) qui sera utilisée par Cantor pour nommer les différents infinis mathématiques L'infini implique plutôt un processus illimité que quelque chose " en acte ", pouvant être identifié. Certains pensent que l'infini n'existe pas en tant que quantité, mais seulement que comme un potentiel: une quantité qui peut toujours devenir plus grande ou plus petite sans que jamais ce devenir ne se transforme en être. L'infini a-t-il une réalité, ou bien est-il une fiction utile au calcul comme le pensait Leibnitz? |

le seul ensemble infini " en acte ", pouvant être équivalent à des parties de lui-même.

Par exemple, l'ensemble infini des nombres pairs est équivalent à l'ensemble infini des nombres entiers dans sa totalité.

En 1873 Cantor prouve que l’ensemble des nombres rationnels est dénombrable (pouvant se mettre en correspondance biunivoque avec l’ensemble des Entiers), un an avant il avait montré suite aux travaux de son ami Dedekind que l’on pouvait définir les nombres irrationnels comme limites de séries convergentes de rationnels.

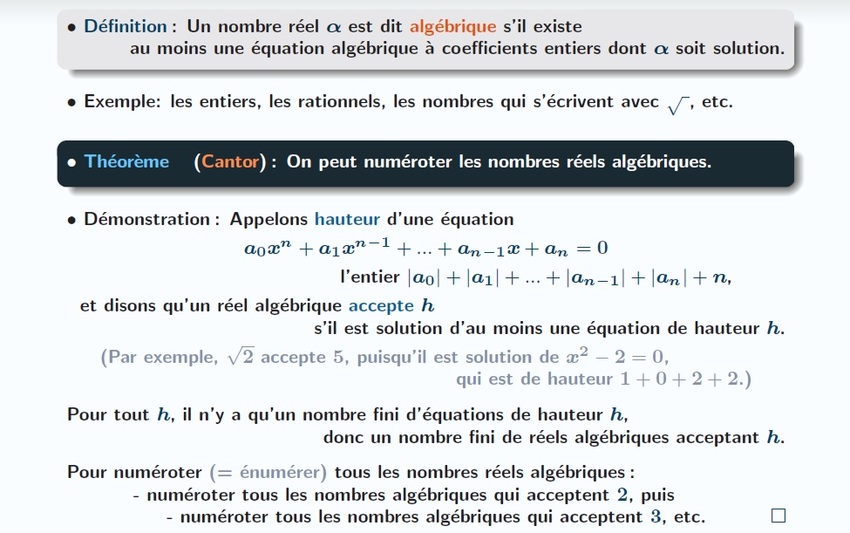

Il montre aussi, que l’ ensemble des nombres algébriques, c’est à dire l’ensembles des nombres solutions des équations polynomiales à coefficients rationnels, est dénombrable.

La démonstration de Cantor n’est pas difficile.

(texte d'après Nicolas Oresme, Université de Caen)

En décembre 1873 il montre que l’ensemble des nombres réels n’est pas dénombrable.

Un nombre transcendant est un nombre qui ne peut pas être solution d’une équation polynomiale à coefficient rationnels.

1851-Liouville | En 1851 Liouville avait établi l’existence de tels nombres.

Cantor venait donc de démontrer que presque tous les nombres réels étaient des nombres transcendants ! En 1874, à la question de Dedekind sur l’existence ou non, et Dedekind pensait que non, d’une correspondance biunivoque entre l’intervalle des nombres réels [0,1] et les points du carré unitaire fermé ([0,1]x[0,1]), Cantor démontre l’existence d’une correspondance biunivoque entre les nombres réels de l’intervalle [0,1] et l’ensemble des points d’un espace à p dimensions. Il écrit à son ami : « Je le vois, mais je n’y crois pas ! » Il existe donc un certain nombre d'ensembles infinis équivalents. R est en bijection avec tout intervalle de longueur non nulle R est en bijection avec P(N) [ensemble de tous les sous-ensembles de N] R est en bijection avec R 2 Cantor a longtemps cherché et cru que c´était faux mais il découvre à sa stupéfaction que R est en bijection avec R 2 . |  Julius-Wilhelm-Richard-Dedekind |

R ←→ P(N) ←→ P(Z) ←→ P(Z ∗ −) × P(Z+)

R ←→ P(N) 2 ←→ R 2

– R est en bijection avec R n ; – cela implique en particulier que R est en bijection avec tout R-espace vectoriel et tout C-espace vectoriel .

Démonstration de l’existence d’une bijection entre R et Rn source

Dans une lettre, adressée le 20 juin 1877 à Dedekind , Cantor donne la première démonstration de l’existence d’une bijection entre R et Rn (où R désigne l’ensemble des nombres réels). Plus précisément il montre l’existence d’une bijection entre le segment [0 , 1] (l’ensemble des réels compris entre 0 et 1) et le carré [0 , 1]2 (l’ensemble des couples de réels (x, y), tels que x et y soient compris entre 0 et 1). L’argument est le suivant : Si x est un réel compris entre 0 et 1, on peut considérer l’écriture «décimale illimitée», selon l’expression de Cantor, de tout réel qui s’écrit d’une façon et d’une seule sous la forme x = 0, α1 α2 α3 … αn …. où αn est la nème décimale du nombre réel x. Pour construire une bijection de [0 , 1]2 dans [0 , 1] il faut associer à un couple de réels (x, y) (compris entre 0 et 1) un réel z (toujours compris entre 0 et 1) ; l’idée de Cantor est de procéder comme suit : Si x = 0, α1 α2 α3 … αn …. et y = 0, β1 β 2 β 3 … βn …. On pose z = 0, α1 β1α2 β 2 α3 β 3… αn βn …. La (2n - 1)ème décimale de z est donc la nème décimale de x et la (2n)ème décimale de z est la nème décimale de y. Il est facile de vérifier que cette application est bijective. Dans sa lettre, Cantor donne une solution un peu plus générale que celle-ci, montrant directement l’existence d’une bijection entre [0 , 1] et [0 , 1]n pour tout entier n, mais le principe de la démonstration est celui décrit ci-dessus.Enfin le fait d’avoir montré l’existence d’une bijection entre [0 , 1] et [0 , 1]n permet de déduire celle d’une bijection entre R et Rn.

Il existe en effet des bijections entre un segment des réels et l’ensemble de tous les réels (par exemple l’application tangente) et il est ensuite facile de vérifier que deux segments quelconques (non vides) sont en bijection entre eux.

La surprise de Cantor devant ce résultat vient d’une certaine confusion, qui sera précisément levée par ses travaux, entre dimension d’espace vectoriel et cardinal d’un ensemble.

En tant qu’espaces vectoriels, R et Rn sont très différents. Mais en tant qu’ensemble de points, ils sont en bijection et ont donc le même cardinal.

Le premier résultat fondamental de la théorie des cardinaux, a consisté à montrer qu’il n’existe pas de bijection entre l’ensemble des entiers et celui des réels (lettres de novembre-décembre 1873 à Dedekind), ouvrant la voie à l’idée de hiérarchie des infinis.

Celle-ci sera établie de façon générale par le « théorème de Cantor », énonçant qu’il n’existe pas de bijection d’un ensemble dans son ensemble des parties.

L’existence d’une bijection entre R et Rn une sorte de pendant positif du théorème de Cantor, montrant que des ensembles infinis, très différents d’un point de vue mathématique, ont néanmoins même « nombre d’éléments ».

Ce sont ces deux résultats qui montrent la richesse de la théorie cantorienne des cardinaux.

Mais alors, pourquoi pas une infinité?

Une infinité d'ensembles infinis!

C'est un infini d'ordre 2.

Alors pourquoi pas l'ordre 3, puis 4, ou ... même, infini.

Ces ensembles d'ensembles infinis sont bien sûr en nombre infini.

On peut encore continuer comme ça...jusqu'à l'infini!

Ce serait alors, l'infini absolu, le vrai.

Le plus grand infini concevable.

Il est noté " ωp

Donc Cantor était obsédé par la notion d’infini et peut-être pas seulement pour des raisons théologiques.

Cantor a eu l’idée d’ajouter à la suite infinie des Entiers, 1, 2, 3,. . .la dernière lettre de l’alphabet Grec oméga, ω qui devenait le premier nombre après tous les nombres finis : c’était le premier nombre transfini.

On peut alors écrire

1,2,3,…, ω+1, ω+2, ω+3,….

Puis, on se dit pourquoi s’arrêter là, en effet on peut continuer 1,2,3,…, ω, ω+1, ω+2, ω+3,…

jusqu’à 2ω, 2ω+1, 2ω+2, 2ω+3,…

puis après 3ω,…,4ω,...

jusqu’à donc ω2 .

1,2,3,…, ω+1, ω+2, ω+3,….2ω 3ω 4ω … ω2

1,2,3,…, ω+1, ω+2, ω+3,…. 2ω 3ω 4ω … ω 2 ...ω3... ω4… ωω... ωωω

C’est enivrant ; après un moment on ne sait plus réellement ni où on est ni où on va.

Le nombre suivant est w élevé à la puissance w de façon indéfinie, ce qui donnerait

ωωωωωωωωωωωωωωωωωωωωω…

Ce nombre est la plus petite solution de l’équation

x = ωx

Ce nombre est dénommé, on ne sait pas trop pourquoi, ε0 (Epsilon zéro).

Comme on le voit cette approche est d’une puissance imaginative fantastique et on ne sait plus si c’est vraiment encore tout à fait des mathématiques.

Comme on le voit cette approche est d’une puissance imaginative fantastique et on ne sait plus si c’est vraiment encore tout à fait des mathématiques.

Leopold-Kronecker | Poincaré, le grand mathématicien Français parle lui de désastre à propos de cette théorie , Kronecker lui traite carrément Cantor de corrupteur de la jeunesse ! Mais la topologie moderne et un grand nombre parmi les résultats de mathématique les plus abstraits du 20 ème siècle en découlent directement en tant que généralisations. En fait on peut dire que la mathématique du 19 ème siècle était moins abstraite et plus concernée par les cas spéciaux et les formules comme les séries infinies de Taylor par exemple. La mathématique du 20 ème siècle est arrivée au niveau d’abstraction des ensembles théoriques. Cela est dû pour une part à Cantor qui est accusé d’avoir fait perdre sa partie concrète aux mathématiques en passant par exemple de l’analyse pure et dure à l’analyse théorique ! |

En fait ceci est très controversé.

Et, ce qui n’aide pas beaucoup, non seulement nous sommes en pleine controverse mais en fait nous avons aussi des contradictions. Et c’est là plus qu’une simple opinion. Il existe certains cas où on ne peut pas ne pas être gravement troublé par le non-sens obtenu. Ainsi il existe un théorème de Cantor qui dit que pour tout ensemble infini, il existe un ensemble infini plus grand qui est l’ensemble de tous les sous-ensembles de cet ensemble , ce qui semble résonner de façon très raisonnable. C’est le fameux argument diagonal de Cantor.

Argument diagonal de Cantor

Comment faire la liste de tous les nombres imaginables, et, cependant, en trouver encore d'autres ? Comment prouver qu'il existe plus d'un seul type d'infinis !

Nous allons prendre les nombres décimaux compris entre 0 et 1;

ceux qui commencent par 0, …

Avec la règle de la diagonale de Cantor,

il est toujours possible de former un nouveau nombre, quel que soit l'inventaire que nous puissions produire.

b est bien un réel compris entre 0 et 1 et, par construction, il n'appartient pas au tableau de correspondance.

C'est un nombre en plus!

L'application de la diagonale de Cantor montre que le tableau ne contiendra jamais tous les nombres réels.

Soit N l’ensemble des entiers naturels qui est infini et dénombrable.

Alors Cantor a prouvé un théorème qui dit que

Théorème L’ensemble 2 N est non-dénombrable. (où 2N est l’ensemble de tous les sous-ensembles de N)

Preuve :

Supposons que 2 N est infini et dénombrable alors on peut le mettre en bijection avec N.On peut alors mettre en correspondance les éléments de N et les élément de 2 N c’est à dire qu’on peut NUMÉROTER les éléments de 2 N, la numérotation serait biunivoque et formellement alors :

il existerait une application bijective f : N ------------> 2 N et donc on pourrait numéroter 2 N de la façon suivante 2 N= {S0 , S1 , S2 ,. . . } où Si =f(i) pour tout i ∈ N.

Considérons alors l’ensemble suivant D={n∈N : n∉ Sn } autrement dit D est un ensemble d’entiers naturels ce pourrait être donc un certain sous-ensemble S k pour un certain nombre naturel k. posons donc D= S k

Maintenant posons-nous la question de savoir si k peut être dans S k c’est à dire si k ∈ S

(1) supposons que oui

k ∈ S k de par la définition de D

il s’en suit que k ne peut appartenir à D={n∈N :n∉Sn }

mais D= S k et donc k ∉ S k est une contradiction.

(2) Maintenant supposons que k ∉ S k;

alors k appartient à D mais D lui-même n’est autre que S k

Donc k est dans S k est une autre contradiction.

Comme ni(1) ni(2) ne peut être possible l’hypothèse que D= S k pour un certain k doit être une erreur .

Donc 2 N est non dénombrable

Récapitulons pour voir comment fonctionne le principe de la diagonalisation.

L’ensemble D est en fait un ensemble diagonal pour la relation : R={(i,j) : j∈f(i) }

comme Si =f(i) , l’ensemble R i ={j :(i,j) ∈R} est tout simplement Si.

Maintenant on s’attend à ce que D diffère de tous les ensembles R i

c’est à dire de tous les Si et c’est ceci justement qui sera prouvé par contradiction. Comme D est différent de chaque Si , D∉ f(N) et donc l’hypothèse que f était une bijection est hypothèse incorrecte

On a donc prouvé qu’il existe un sous-ensemble de N qu’il n’est pas possible de numéroter.

Que donc N et 2 N ne peuvent pas être isomorphes et malgré que N soit infini on a prouvé que 2 N contient strictement plus d’éléments et est en quelque sorte plus grand .

Paradoxalement votre

Donc si on est convaincu de cela, que se passe-t-il si on applique le théorème à l’ensemble Universel ? L’ensemble Universel est l’ensemble toute chose; c’est l’ensemble dont la fonction caractéristique des éléments est 1 pour tout objet . Tout objet appartient à cet ensemble. En considérant l’ensemble de tous les sous-ensembles de cet ensemble Bertrand Russell a détecté un fameux problème.- les redoutables paradoxes de Bertrand Russel viennent tout ébranler, alors qu’ils paraissent pourtant enfantins : Peut-on par exemple parler de l’ « ensemble de tous les ensembles » ?

- Si c’est un ensemble, il doit se contenir lui-même?

- Sinon, ce n’est pas un ensemble ?

- Pire, le fameux « paradoxe du barbier » : imaginez un pays dans lequel il n’y a qu’un barbier, et que celui-ci rase tous les gens qui ne se rasent pas eux-mêmes, et seulement ceux-ci.

- Nous nous retrouvons avec deux ensembles bien définis. Mais qui rase donc le barbier ?

- S’il se rase lui-même, le barbier ne devrait pas le raser, mais c’est lui le barbier !

- Et s’il ne se rase pas, alors le barbier (lui, donc) devrait le raser.

- Vous suivez ?! On ne s’en sort pas, c’est un cauchemar.

- Bref, les meilleurs mathématiciens et logiciens suaient sang et eau sur ce problème au début du XXe siècle (le même Russel, dans un travail commun avec Whitehead, vont jusqu’à prendre 350 pages pour démontrer… que 1 + 1 = 2 !)

- Pendant ce temps, d’autres mathématiciens, et non des moindres, trouvaient ce travail inutile : pour eux, cette démarche enlève tout son sens aux mathématiques, celles-ci n’avanceront jamais ainsi, c’est une mécanique vaine.

- Il faut garder la place de l’intuition, et ne pas penser que même muni d’un système d’axiomes parfait, on parviendra à faire avancer les maths de façon automatique.

- Une citation de Henri Poincaré, très grand mathématicien également, mais français, montre très clairement sa position :

« Un naturaliste, qui n’aurait jamais étudié l’éléphant qu’au microscope, croirait-il connaître suffisamment cet animal ? Eh bien ! En Mathématiques, il y a quelque chose d’analogue. d’opérations élémentaires quand on aura examiné ces opérations les unes après les autres et qu’on aura constaté que chacune d’elles est correcte, croira-t-on avoir compris le véritable sens de la démonstration ? »

- Hilbert est au contraire passionné par cette quête, et persuadé qu’elle aboutira.

- On doit pouvoir trouver un système parfait, dans lequel tout pourra être démontré ou réfuté.

- Admettant que l’on peut avoir plusieurs modèles, plusieurs mondes derrière un même système d’axiomes, il va même jusqu’à affirmer que l’on pourrait donner d’autres noms aux objets mathématiques sans problème : remplacer par exemple “point” par “bière” et “droite” par “table”, et affirmer que par deux bières, il passe une et une seule table.

- Pourquoi pas ? Tant que la cohérence de l’ensemble « définitions/Postulats/démonstration » n’est pas atteint, ce n’est pas gênant. La seule chose qui compte, c’est la validité relative des enchaînements de propositions.

- Le paradoxe de Berry a été formulé par Bertrand Russell en 1906. On le trouve dans un article, paru en français cette même année, de la Revue de métaphysique et de morale. Russell introduit, dans une discussion à propos du paradoxe de Richard, le « plus petit entier non nommable en moins de dix-huit syllabes qui paraît être ainsi nommé en dix-sept syllabes », et attribue cette définition paradoxale à un bibliothécaire londonien, G. G. Berry.

David Hilbert

Hilbert enseigne d’abord à Koninsberg puis à Gottingen où il finira sa carrière.

Les 23 problèmes de Hilbert

En 1900, Hilbert a fait un tour d'horizon des mathématiques, définissant ses fameux 23 problèmes. Il a été le mathématicien qui a le plus influencé la formation des mathématiques au XXe siècle et ceci plus que toute autre personne.

Hilbert a décrit 23 problèmes ou questions qui, selon lui, porteraient les mathématiques à un nouveau niveau s'ils étaient correctement résolus.

La liste, a-t-il dit, n'était pas censée exclure d'autres problèmes, il s'agissait simplement d'un échantillon de problèmes.

Échantillon ou pas, depuis que Hilbert a posé pour la première fois les 23 problèmes, un énorme travail a été fait pour trouver les réponses.

Les mathématiciens ont résolu certains des problèmes en quelques années, et d'autres plus tard, mais certains restent non résolus.

Plus de cent ans après que Hilbert les ait répertoriés pour la première fois, une nouvelle lumière brillante brillerait sur les mathématiques si les problèmes restants pouvaient être résolus.

Les grands problèmes non résolus identifiés par Hilbert sont :

- L'hypothèse de Riemann

- L'extension du théorème de Kronecker-Weber

- Le problème de la topologie des courbes et des surfaces algébriques

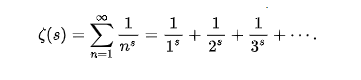

La fonction zêta de Riemann est définie pour tous les nombres complexes s de partie réelle strictement supérieure à 1 par:

Le théorème de Kronecker-Weber établit en théorie algébrique des nombres le résultat suivant : toute extension abélienne finie du corps ℚ des rationnels, c'est-à-dire tout corps de nombres dont le groupe de Galois sur ℚ est abélien, est un sous-corps d'une extension cyclotomique, i.e. d'un corps obtenu en adjoignant une racine de l'unité aux nombres rationnels. Ce théorème a été énoncé par Kronecker en 1853. Sa proposition de preuve était incomplète. Weber en 1886 proposa une nouvelle preuve, qui présentait encore une lacune. Hilbert le montra en 1896 en utilisant des méthodes différentes de celles de ses prédécesseurs, et posa le problème de sa généralisation

. Le théorème est aujourd'hui habituellement démontré comme une conséquence de la théorie des corps de classes.

Cependant, il peut aussi être déduit de l'assertion analogue sur les corps de nombres p-adiques : si p est un nombre premier, et K/ℚp est une extension abélienne finie, alors K est inclus dans une extension cyclotomique de ℚp

Développer une topologie des courbes et des surfaces algébriques.

Ce problème comporte deux parties. La première concerne le nombre de branches réelles d'une courbe algébrique, et leur disposition ; de nombreux résultats modernes (Petrovskii, Thom, Arnold) apportent des informations à leur sujet.

La seconde partie du problème pose la question de l'existence d'un nombre maximal de cycles limite pour une équation différentielle linéaire définie par des polynômes homogènes de degré donné ; cette question est encore ouverte.

C’est dès ses 28 ans qu’il publie son premier résultat important, la résolution du problème de Gordan en théorie des invariants.

C’est dès ses 28 ans qu’il publie son premier résultat important, la résolution du problème de Gordan en théorie des invariants.Dans sa preuve “non constructiviste”, Hilbert étudie en fait les choses de manière très générale, très abstraites.

Il prend un jeu d’hypothèses, certes respectées par les invariants mais aussi par plein d’autres objets et on n’a finalement pas besoin de préciser ce qu’ils sont et il en déduit des propriétés dont celle finalement qui fait le sujet de l’article. En fait, sa théorie est beaucoup plus générale et le résultat sur les invariants n’en est qu’une petite partie, tellement annexe qu’elle ne porte pas le nom de théorème mais de “lemme” ce premier résultat important porte déjà la plupart des marques de Hilbert.

D’abord son coté “bulldozer”, à savoir qu’il s’intéresse à un domaine et résout tout ce qu’il y avait à résoudre.

Ensuite, sa résolution ouvre, comme souvent, nombre de nouvelles questions et champs mathématiques.

Enfin, il raisonne en toute abstraction, sans forcément nécessiter un certain lien avec le “réel”.

En somme, Hilbert ne s’intéresse pas à ce que sont les objets “droite” et “plan”, il s’intéresse seulement aux propriétés qu’ils respectent.

Le fait de savoir s’ils “existent”, s’ils sont représentatifs de notre monde ne l’intéresse pas pour construire son axiomatique.

Il se contente alors pour seule définition :

“Nous pensons trois systèmes différents de choses. Nous nommons les choses du premier système les points […].

Nous nommons droites les choses du deuxième système […]. Nous appelons plans les choses du troisième système. […].

Entre les points, les droites et les plans, nous imaginons certaines relations que nous exprimons par des expressions telles que ”être sur“, ”entre“, ”congruent“.

La description exacte et appropriée au but des mathématiques de ces relations est donnée par les axiomes de la géométrie".

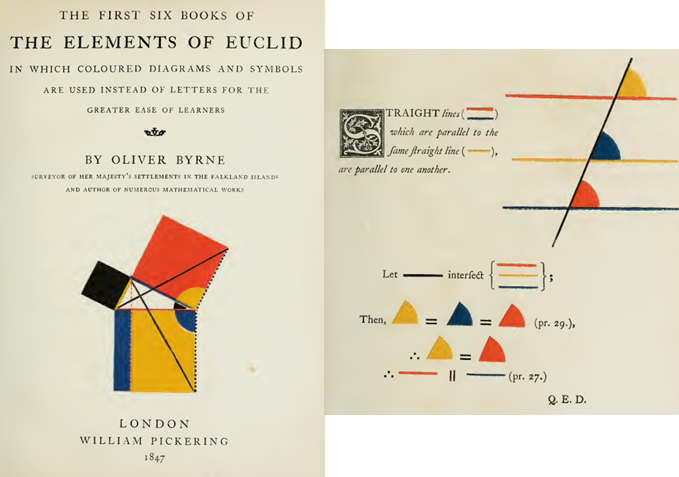

Cela tranche tout particulièrement avec Euclide qui définit d’abord point et droite avant de poser ses axiomes.

Axiomatisation de la géométrie

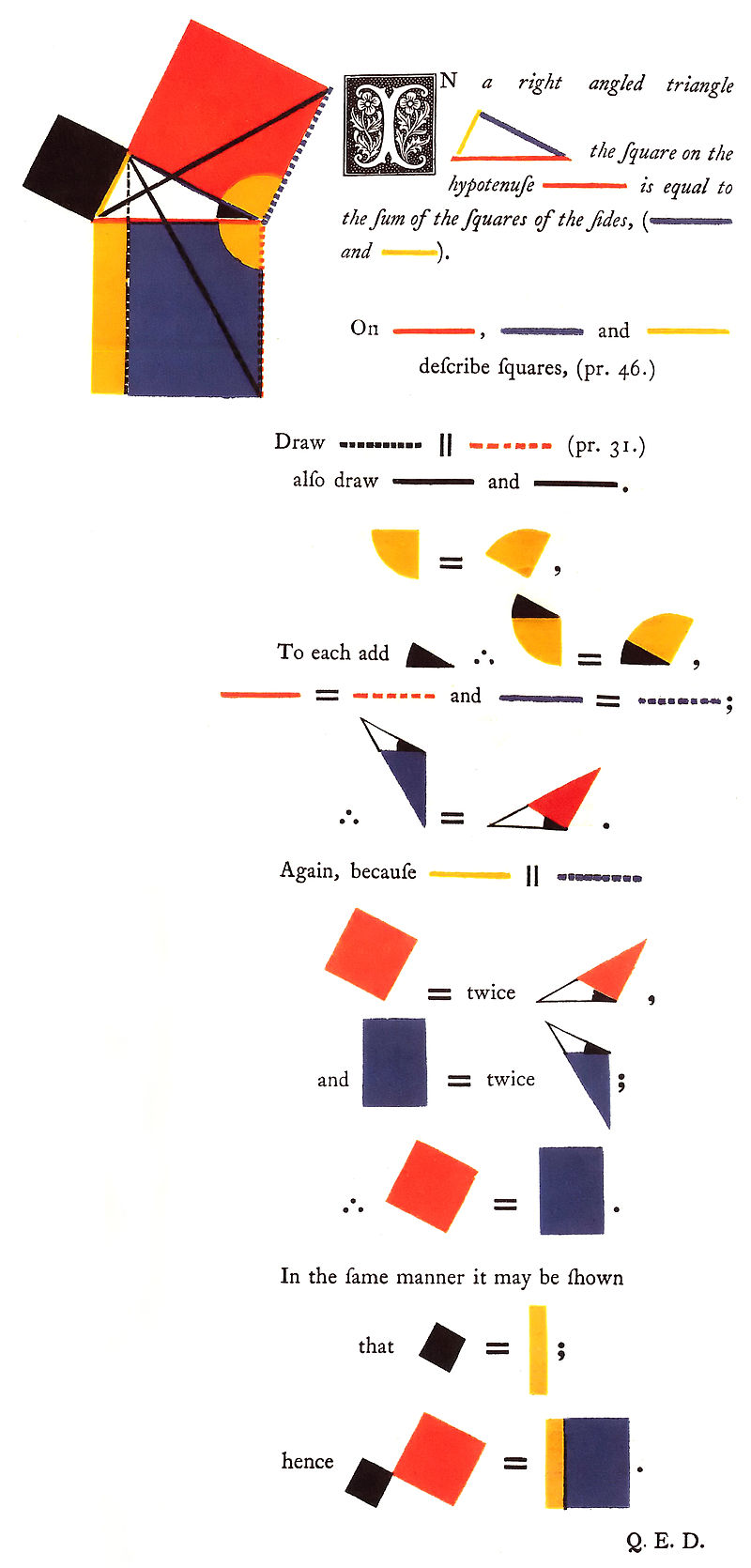

Extrait des éléments d’Euclid dans l’édition d’Olivier Byrne (sans aucun doute la plus belle édition que vous pourrez trouver)

Extrait des éléments d’Euclid dans l’édition d’Olivier Byrne (sans aucun doute la plus belle édition que vous pourrez trouver)

Les axiomes d’Euclide ne conviennent plus aux mathématiciens de cette époque, en particulier, ils acceptent mal l’axiome des parallèles, qui affirme que par un point extérieur à une droite, ne passe qu’une droite parallèle. autres et beaucoup sont persuadés qu’il découle

Extrait des éléments d’Euclid dans l’édition d’Olivier Byrne . Cet axiome parait bien compliqué au regard des autres. En cherchant à démontrer qu’une géométrie où cet axiome est faux ou absurde, ils se retrouvent à créer des géométries certes étranges mais tout à fait cohérentes. Pire encore, Klein parvient à établir une construction qui démontre que s’il existe une incohérence dans sa géométrie non euclidienne, on peut trouver une incohérence similaire dans la géométrie euclidienne : aucune des deux n’est plus cohérente que l’autre! Avec Hilbert, un axiome n’est plus vrai car il traduit l’expérience mais car il s’inscrit dans un système consistant. Cela marque le début des mathématiques modernes et marque aussi un point de rupture avec les autres sciences dont on a souvent eu l’occasion de discuter ici. Ce changement a aussi une autre implication, en tuant le lien avec l’expérience, le problème de l’axiomatisation deviens un problème mathématique et, au même titre que les autres problèmes mathématiques, il pourra être étudié et mener à des démonstrations tel que le théorème de Gödel.

-

Problème de Gordan

Au contraire du grand mathématicien Français, Poincaré, Hilbert le grand mathématicien Allemand aimait la théorie des ensembles. Hilbert eut donc l’idée de résoudre une fois pour toute tous ces problèmes.

En mathématique, une fois un repère défini, on utilise souvent une équation pour représenter une courbe. Si l’on change de repère, l’équation change alors que l’on a toujours à faire à la même courbe. La théorie des invariants consiste justement à étudier ce qui ne change pas en changeant de repère, les caractéristiques propres de la courbe en somme. En 1868, Gordan montre un premier résultat important dans ce domaine et pendant 20 ans, personne ne parviens à aller plus loin jusqu’à ce qu’Hilbert publie ses résultats. Si le résultat fait polémique à l’époque, ce n’est pas tant pour son résultat ( qui vaudra à Hilbert d’entrer de manière fracassante sur la scène mathématique) mais plutôt pour l’originalité que prend ce résultat (C’est une démonstration d’existence pure ). - Dans sa preuve “non constructiviste”, Hilbert étudie en fait les choses de manière très générale, très abstraites. Il prend un jeu d’hypothèses, certes respectées par les invariants mais aussi par plein d’autres objets et on n’a finalement pas besoin de préciser ce qu’ils sont et il en déduit des propriétés dont celle finalement qui fait le sujet de l’article. En fait, sa théorie est beaucoup plus générale et le résultat sur les invariants n’en est qu’une petite partie, tellement annexe qu’elle ne porte pas le nom de théorème mais de “lemme”.

La façon de faire de Hilbert, c’est dire l’utilisation de l’axiomatique remonte donc à l’origine, en fait, à Euclide avec ses fameux postulats.

Hilbert ne l’a pas inventé. Mais il y a ajouté un pas significatif de plus. Hilbert :Méthode Axiomatique Formelle

Hilbert dit qu’il faut utiliser toute la technique de la logique symbolique, dont beaucoup de ses collègues mathématiciens étaient partie prenante soit comme utilisateurs soit comme inventeurs, et proposait d’aller aux conséquences ultimes de l’utilisation d’une telle logique symbolique.

Puisque ce qui jette le trouble et la contraction en mathématique avec la théorie des ensembles est l’utilisation de mots et que les mots peuvent être très vagues, Hilbert propose un ensemble fini d’axiomes et un langage artificiel pour faire des mathématiques. C’est ceci qui est l’idée du formalisme.Formalisme quand tu nous tiens

- En poussant le formalisme à sa limite et en inventant un langage complètement artificiel avec des règles du jeu extrêmement précises, Hilbert pensait éliminer tous ces problèmes comme ceux détectés par Russell. Le paradoxe de Russell

- C’était un véritable programme très ambitieux..

- Hilbert ajoutait, et c’est l’une des contributions majeures de son apport :ces règles doivent être si précises que l’on pourrait avoir un vérificateur mécanique de ces preuves. Donc il est complètement certain, objectif et mécanique que la preuve obéit ou non uniquement aux règles. Il ne doit pas y avoir d’élément humain, d’élément subjectif et il n’est pas question d’interpréter.

Le paradoxe de Russell, ou antinomie de Russell, est un paradoxe très simple de la théorie des ensembles (Russell lui-même parle de théorie des classes, en un sens équivalent), qui a joué un rôle important dans la formalisation de celle-ci. Il fut découvert par Bertrand Russell vers 1901 et publié en 1903. Il était en fait déjà connu à Göttingen, où il avait été découvert indépendamment par Ernst Zermelo, à la même époque, mais ce dernier ne l'a pas publié.

Énoncé du paradoxe

On peut formuler le paradoxe ainsi : l'ensemble des ensembles n'appartenant pas à eux-mêmes appartient-il à lui-même ? Si on répond oui, alors, comme par définition les membres de cet ensemble n'appartiennent pas à eux-mêmes, il n'appartient pas à lui-même : contradiction. Mais si on répond non, alors, il a la propriété requise pour appartenir à lui-même : contradiction de nouveau.

On a donc une contradiction dans les deux cas, ce qui rend l'existence d'un tel ensemble paradoxal.

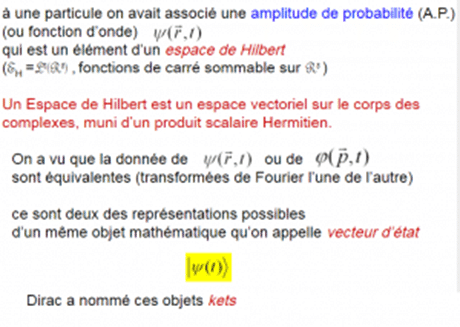

Il n’hésite pas non plus à dire qu’après avoir réformé les mathématiques, il s’attaque à la physique et quand il en aura fini il s’attaquera à la chimie qui à l’époque était, selon ses mots, “comme faire de la cuisine dans une école pour filles”. En 1915, il produira une théorie de la relativité et il a eu une influence indirecte déterminante pour l’essor de la mécanique quantique. Il se trouve que les outils mathématiques de la mécanique quantique sont une application directe de la théorie des équations intégrales. Et puis il eut un tout petit pépin. Introduction à la Mécanique Quantique

Introduction à la Mécanique Quantique- Le pépin c’est d’abord Kurt Gödel en 1931 et puis Alan Turing en 1936.

- Kurt Gödel en 1931

- Alan Turing en 1936

- C’est en tous cas ce qu’impliquait la proposition de Hilbert.

- Gödel a choqué en montrant que cela ne marcherait pas en 1931.

- Quant à Alan Turing il y est allé plus loin peut-être.

- Résumons schématiquement ce qu’ils ont fait en commençant par Gödel.

- Gödel part de la proposition « cette proposition est fausse » donc ce que je dis est un mensonge.

- Résumons

- L’incomplétude des systèmes formels

- Indiquons le schéma d’intervention autour duquel Gödel a bâti son fameux théorème

- 1) Comment construire une formule arithmétique G représentant l'énoncé suivant: " La formule G n'est pas démontrable " ? G est vraie ssi elle n'est pas démontrable, G dit quelque chose d'elle même , elle est autoréférentielle donc source de paradoxes. 2) Gödel montre que G est démontrable ssi sa négation non G est démontrable. Si G et non G sont démontrables, l'arithmétique est inconsistante. Si l'arithmétique est consistante , alors ni G , ni non G ne sont démontrables. G est une formule indécidable. 3) Bien que G ne soit pas démontrable, elle est arithmétiquement vraie. 4) Puisque G est vraie et qu'elle est indécidable, alors les axiomes sont sémantiquement incomplets . Donc il y a des formules vraies qui ne sont pas décidables au sein du système. 5) Gödel construit une formule A qui représente la proposition " l' arithmétique est consistante".

- Si A alors G

- A implique G est démontrable, or A n'est pas démontrable dans le système. Si A était démontrable, alors G le serait aussi ; donc la formule est indécidable.

- Ainsi, si l'arithmétique est consistante, alors on ne peut prouver dans l'arithmétique la formule qui exprime cette consistance

Un exemple de formalisation

On dispose un nombre n d'allumettes sur une table. Les joueurs A et B jouent chacun leur tour et peuvent retirer de 1 à 3 allumettes du tas. Le joueur qui retire la dernière allumette a gagné. Exemple de partie On dispose 10 allumettes. C'est au joueur A de commencer.- Le joueur A retire 2 allumettes, il en reste 8

- Le joueur B retire 1 allumette, il en reste 7

- Le joueur A retire 3 allumettes, il en reste 4

- Le joueur B retire 2 allumettes, il en reste 2

- Le joueur A retire 2 allumettes, il n'en reste plus, le joueur A a gagné.

- Le système formel

- Les formules

- La négation des formules

- Les règles d'inférence

- Voici la liste des règles d'inférence de notre système (n remplace n'importe quel entier):

- ABn => AAn+1

- ABn => AAn+2

- ABn => AAn+3

- ABn => ABn+4

- BAn => BBn+1

- BAn => BBn+2

- BAn => BBn+3

- BAn => BAn+4

- Les Axiomes

- Testons notre théorie

- L'ordinateur démontre tout

- Consistance, complétude...

- Il démontrera AB7654 et pas BB7654 (la négation de AB7654)

- Il démontrera BB7654 , et pas la formule AB7654

- Il démontrera la formule AB7654 et la formule BB7654

- Il ne démontrera ni AB7654 , ni BB7654

- Résumons. 1931 Gödel « cette proposition est non-démontrable » surprise. Puis est arrivé Turing. 1936 Turing Il commence lui, le premier à parler d’ordinateur. 1936 Turing ordinateur Turing a dû inventer l’ordinateur puisque Hilbert parlait d’utiliser obligatoirement des procédures mécaniques pour vérifier les preuves mathématiques. Turing se disait que ce dont Hilbert parlait doit être un programme d’ordinateur pour vérifier les preuves. Mais d’abord il fallait à Turing spécifier ce qu’était un ordinateur et c’est exactement ce qu’il y a dans sa publication de 1936 et c’est la machine de Turing, à une époque où il n’existait pas d’ordinateur ! On peut dire que c’est de l’invention, sur le papier, de l’ordinateur qu’il s’agit. Ce que Turing a montré en fait c’est qu’il existe des assertions concrètes qui échappent à la puissance des mathématiques. Actuellement , on pense aux ordinateurs en tant qu’appareils physiques et donc ils ressemblent aux objets physiques. C’est en fait une machine qui va au-delà, c’est une idéalisation du travail physique et nous avons donc cette machine qui marche vraiment et Turing tombe alors sur le problème de son arrêt.

- 1936 Turing ordinateur Le problème de l’arrêt

- Car si on pouvait prouver qu’un programme s’arrête ou non, alors ceci implique qu’on peut exécuter toutes les preuves possibles rangés par ordre de longueur et vérifier qu’elles sont correctes et éventuellement soit trouver une preuve que le programme va s’arrêter ou trouver une preuve qu’il ne va pas s’arrêter.

- Actuellement et en pratique, exécuter toutes les preuves possibles exige une quantité de temps astronomique. Imaginons combien, déjà, il y a de preuves de la longueur d’une seule page seulement ! On ne peut en arriver au bout ! Mais en principe conformément au système axiomatique formel de Hilbert on peut exécuter toutes les preuves possibles rangées par ordre de taille et s’assurer qu’elles vérifient ou non les règles. Donc si on dispose d’une axiomatisation formelle des mathématiques qui nous permette de prouver qu’un programme s’arrête ou non cela donnerait justement une procédure mécanique en exécutant toutes les preuves possibles rangées par ordre de taille et de décider si un programme s‘arrête ou non.

- Turing a montré qu’on ne peut pas faire cela.

- Sa preuve utilise l’argument diagonal de Cantor. Toutes ces idées sont connectées entre elles. On voit que le travail de Turing trace les limites des mathématiques de façon plus naturelle parce qu’il est question d’un appareil physique, d’un ordinateur.

- 1936 Turing ordinateur Problème de l’Arrêt naturel

Oups ! Une machine formelle à poser et à résoudre tous les problèmes ?

- Tout est déjà là, dés le début, en 1936. L’invention de l’ordinateur est une réponse à un argument théorique fou. On n’a certes pas en jeu les milliards de dollars de la technologie en 1936 , mais les jeux sont faits, tout est posé, à l’état embryonnaire bien sûr, dans cet article de 1936 ! Von Neumann lui, l’avait vu : la machine universelle de Turing s’identifie à la machine programmable capable de prendre en charge par le calcul n’importe quel problème . Il existait, bien sûr, déjà bien avant Turing des machines à résoudre des problèmes par le calcul, mais ces machines ne prenaient en charge par le calcul qu’un type très spécifique de problèmes. Ce n’est pas pour rien que John Von Neumann eut l’idée du logiciel et fut le premier programmeur de l’histoire de l’informatique, il a su voir cette flexibilité, cette notion potentielle d’universalité du calcul de la machine de Turing.

- Toute la Technologie est là, en condensé.

- Dans le papier de Turing, c’est plus explicitement que le langage de programmation est donné et c’est d’ailleurs un authentique langage machine.

- Bien sûr, maintenant le langage machine est mal vu, un langage dont personne d’équilibré ne voudrait pour programmer. On peut se rendre compte maintenant que si Turing avait utilisé un langage plus complexe, il aurait été obligé d’introduire un relais supplémentaire constitué par un manuel minimal d’utilisation de ce langage dans le papier de 1936, et que donc personne n’aurait rien compris à son véritable résultat de calculabilité.

- Qu’en est-il actuellement et qui se préoccupe vraiment des problèmes de fond de la mathématique ?

- Hilbert est mort, la II ème guerre est passée et le monde va dans des directions de moins en moins philosophiques. D’ailleurs les questions philosophiques de fond ont tendance à moins intéresser depuis qu’on voit de jeunes morveux devenir milliardaires juste en démarrant des starts-up sur le Web !

- Ce qui est insupportable en fait, c’est que même dans le monde abstrait des mathématiques pures, les mathématiciens eux-mêmes affirment que dans la pratique ils font exactement de la même façon ce qu’ils ont toujours fait, et qu’en définitive tout cela ne s’applique pas aux problèmes qui les préoccupent !

- On dirait de cette amnésie une technique névrotique compensatrice de l’espace mental que Freud a tenté de si bien expliquer.

- Les conséquences de ces résultats sont soigneusement refoulées ou noyées dans un verbiage théologique où l’incantatoire prend si facilement le pas sur le rythme d’un débat qui n’en est pas un.

Et en Physique, que ce passe-t-il?

Vous avez dit méta quoi déjà ?- Regardons un autre domaine non moins passionnant, la physique.

- Bien que le modèle de Newton soit en progrès significatif par rapport au modèle de Ptolomée, il est insuffisant ou INCOMPLET, dans le sens où le système explicatif déduit du modèle Newtonien n’est pas un espace fermé borné , il existe des trous, i.e. beaucoup de phénomènes physiques ne reçoivent pas d’explication dans le modèle d’Univers de Newton.

- Dans le modèle d’Einstein les vitesses relatives apparaissent de manière plus significative et les concepts qui paraissaient les plus stables éclatent, ainsi ni la masse ni même le temps ne sont invariants et peuvent être vus comme des VARIABLES seule la vitesse de la lumière est déclarée constante dans tout repère d’inertie !

- Si la théorie restreinte reste encore susceptible d’être capturée par notre intuition moyennant un coût de difficulté ne dépassant pas les mathématiques élémentaires, la théorie générale, elle, échappe à notre simple bon sens et à nos raisonnements linéaires car la théorie est en réalité décrite dans un espace géométrique abstrait d’ordre supérieur à 3 où la visualisation intuitive humaine ne peut plus se faire naturellement et où donc des relais abstraits sont nécessaires, pour par exemple, simplement percevoir les données mécaniques d’un problème.

- Les déformations et les distorsions possibles dans cette physique impliquent la maîtrise d’outils mathématiques très puissants comme la manipulation correcte des règles du calcul tensoriel qui ne représentent que le moindre des pré-requis pour accéder à ce langage abstrait capable de décrire les faits de cette physique.

- Actuellement, 4 types de force ont été distingués par les physiciens(- certains physiciens soupçonnent l’existence d’une 5EME force fondamentale.) :

- c’est la force la plus faible –peu sensible à l’échelle des particules à cause de leurs petites masses elle devient sensible à l’échelle macroscopique mais aussi à l’échelle limite de Planck c’est à dire aux ultra très petites dimensions (10-33 cm (la plus petite distance possible selon Planck qui est d’ailleurs parcourue en 10-43 s par la lumière)

- -L'interaction électromagnétique (responsable de la cohésion des molécules)

- -L’interaction faible (responsable de la radioactivité béta (désintégration))

- -L'interaction forte (responsable de la cohésion des noyaux atomiques)

- Avant la théorie quantique, les forces se transmettaient à distance par l'intermédiaire d'un mystérieux champ de force émis par les particules. Après la théorie quantique, les forces ne s'exercent entre deux fermions que s'il y a échange d'une particule médiatrice, appelée boson. Or plus le boson sera lourd, plus l'interaction sera de courte portée. Cette théorie porte le nom indigeste d'électrodynamique quantique. Dans les années 1920 Thomas Kaluza et Oscar Klein ont tenté d’unifier les interactions électromagnétique et gravitationnelle à partir du formalisme de la relativité générale.

- L'électro-dynamique quantique ou QED

- Richard Feynman a étendu cette méthode à l'électrodynamique dans une contexte quantique. Les interactions quantiques sont alors décrites comme des petites perturbations locales du champ électromagnétique. Les résultats ainsi obtenus sont en accord jusqu'à la huitième décimale avec l'expérience, faisant de la QED la théorie la plus exacte que l'Humanité ait jamais conçu. Selon la QED, les interactions électromagnétiques se ramènent à l'échange de photons entre particules chargées. Le photon est donc le quantum de l'interaction électromagnétique. La constante de couplage a la valeur de 1/137. Enfin, la QED est renormalisable, c'est-à-dire qu'il est possible, après des manipulations mathématiques spéciales, d'obtenir une valeur finie pour le calcul des probabilités de diffusion électromagnétique.

Cependant, malgré ses succès retentissants, la QED ne répond pas a une question fondamentale : quelle est la nature profonde de l'interaction électromagnétique ? Un début de réponse à cette question a été donné en abordant la QED sous l'angle des symétries.

Cependant, malgré ses succès retentissants, la QED ne répond pas a une question fondamentale : quelle est la nature profonde de l'interaction électromagnétique ? Un début de réponse à cette question a été donné en abordant la QED sous l'angle des symétries.

- Les symétries de la QED

Phase en 3 points A, B et C de l'espace

Si l'on procède à un changement global du potentiel, cela revient à modifier partout la valeur de la phase de la même quantité, donc à faire tourner tous les segments d'un même angle. Du coup, après cette opération, les ressorts ne seront toujours pas ni tendus, ni comprimés et n'exerceront donc toujours aucune tension.

Phase en 3 points A, B et C de l'espace

Si l'on procède à un changement global du potentiel, cela revient à modifier partout la valeur de la phase de la même quantité, donc à faire tourner tous les segments d'un même angle. Du coup, après cette opération, les ressorts ne seront toujours pas ni tendus, ni comprimés et n'exerceront donc toujours aucune tension.